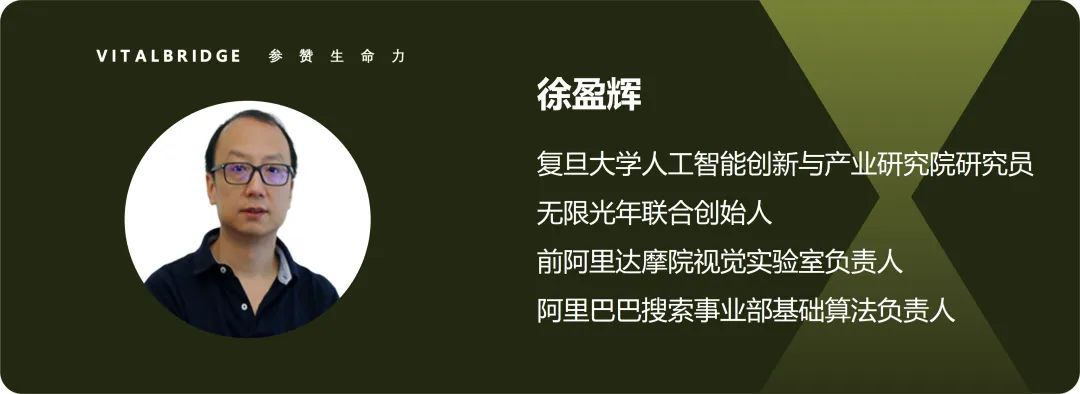

复旦大学AI³徐盈辉研究员:Agent的可视化创作界面 ——Agent Insights

复旦大学AI³徐盈辉研究员:Agent的可视化创作界面 ——Agent Insights传统 LLM-based AI Agent 运维平台在复杂应用开发方面存在一定局限 ,复旦大学人工智能创新与产业研究院(AI³)徐盈辉研究员与 AI2Apps 团队打造的 AI2Apps 可视化集成开发环境集成了工程级的开发工具,覆盖 AI Agent 完整开发周期,具有完全开放的扩展性,并自带浏览器沙盒环境,借鉴 Figma 的理念